1. Yandex开源LLM训练工具,节省高达20%的GPU资源

Yandex 最近推出了 YaFSDP,这是一种用于训练大型语言模型 (LLM) 的开源方法。YaFSDP 是目前最有效的公开可用工具,用于增强 GPU 通信并减少 LLM 训练中的内存使用量,与 FSDP 相比,其训练速度提升最高可达 26%,具体取决于架构和参数数量。通过使用 YaFSDP 减少 LLM 的训练时间可以节省高达 20% 的 GPU 资源。

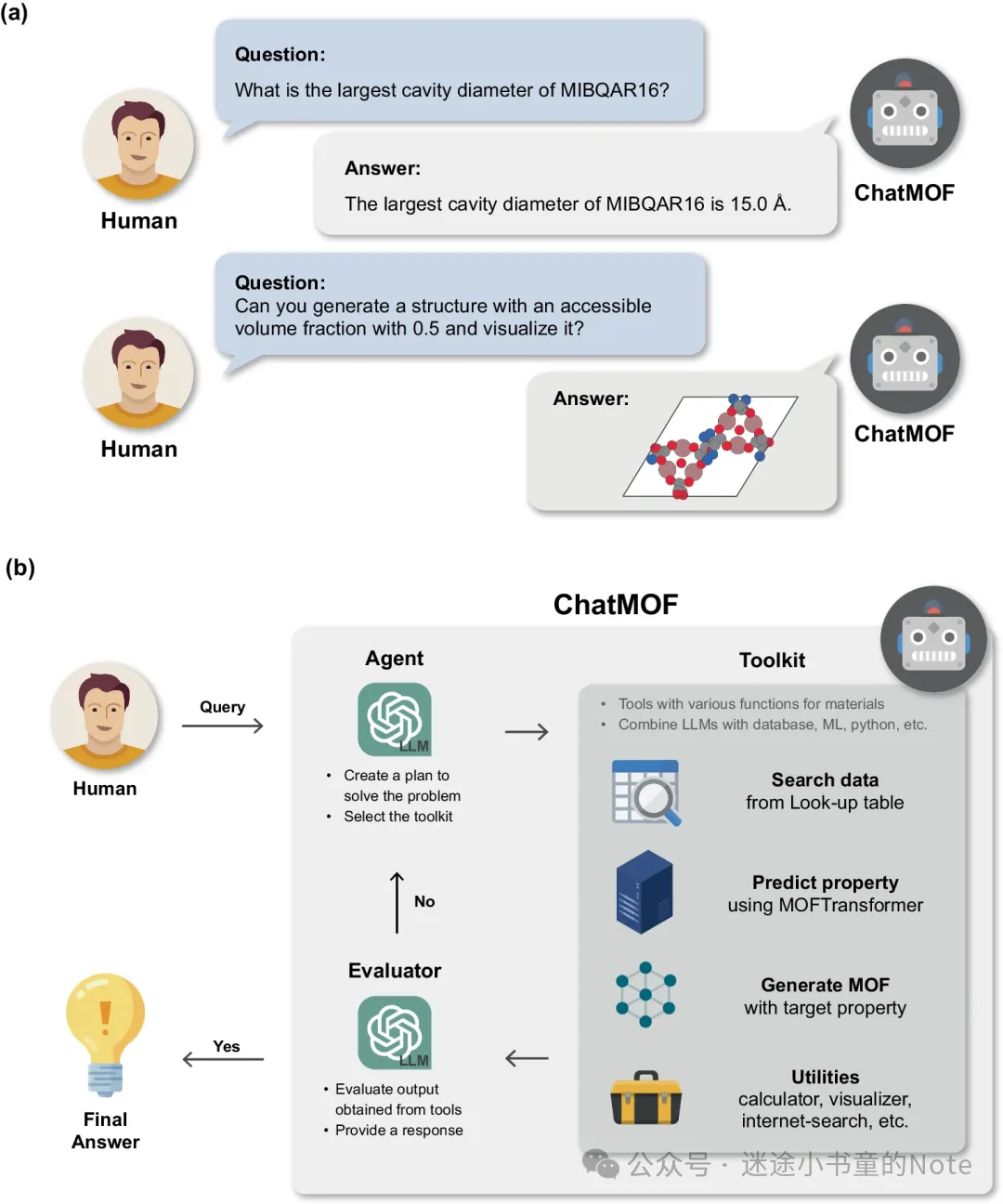

2. ChatMOF利用LLM预测和生成金属有机框架,准确率达95.7%

韩国科学技术院 KAIST 团队提出了一种 AI 系统——ChatMOF,用于预测和生成 MOF。通过利用大语言模型 (GPT-4、GPT-3.5-turbo 和 GPT-3.5-turbo-16k),ChatMOF 从文本输入中提取关键细节并提供适当的响应,从而无需进行严格而正式的结构化查询。

ChatMOF 由三个核心组件组成(即智能体、工具包和评估器),它形成了一个强大的管道,可管理各种任务,包括数据检索、属性预测和结构生成。ChatMOF 的搜索准确率高达 96.9%,预测准确率高达 95.7%。此外,它还成功地从自然语言中创建了具有用户所需属性的材料。

LLM 充当中央协调器,管理和评估流程,类似于中央处理单元 (CPU) 在计算中的运行方式。ChatMOF 使用 LLM 系统地组织和应用各种工具来收集信息,类似于计算机编程中执行良好的算法。这种协同作用使系统能够精确预测材料属性,从文本挖掘数据库中检索合成方法,并制造具有预设属性的新材料。

ChatMOF 由三个主要组件组成:智能体、工具包和评估器。智能体通过四个主要操作阶段(即数据分析、操作确定、输入管理和结果观察)处理人类查询。

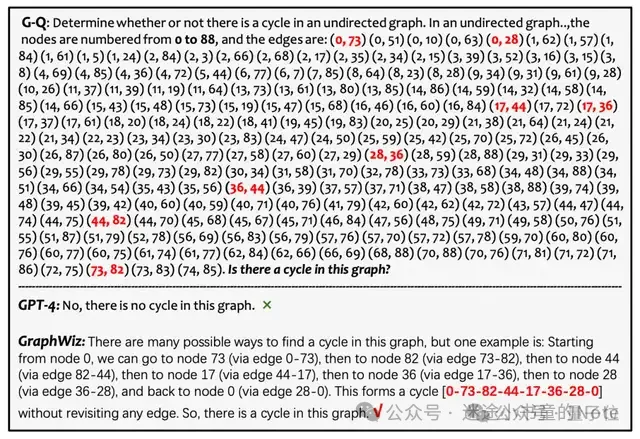

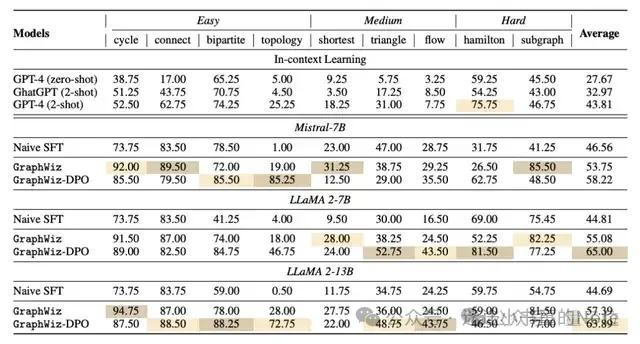

3. 港科大7B模型搞定图推理

港科大团队开发的GraphWiz提升了目前开源的大型模型在解决各种图推理任务时的能力,已经胜过了GPT-4。

这突显了GraphWiz在空间推理和记忆保持方面的能力。该模型已经有效地吸收了图论的基本原理,并能够自主地在大规模且复杂的图结构中进行导航和推理。GraphWiz在处理复杂图问题方面的能力,证明了其在实际应用中的巨大潜力。

4. 极佳科技联合清华发布国产Sora模型

世界模型公司极佳科技联合清华大学自动化系正式发布中国首个超长时长、高性价比、端侧可用的Sora级视频生成大模型视界一粟 YiSu。

具有以下特点

- 拥有模型原生的16秒超长时长,并可生成至1分钟以上

- 同时还拥有超大运动、超强表现力、懂物理世界等众多优势

- YiSu模型成本更低、速度更快、端侧可用

视界一粟 YiSu基于团队自研的视频生成大模型技术,并没有止步于DiT,而是融合LLM和扩散模型的自研架构,结合各种路线的优势,在多模态融合、训练效率、推理效率、模型效果等方面达到极致的优化,打造视频生成的最佳方案。

该工具目前还无法体验。