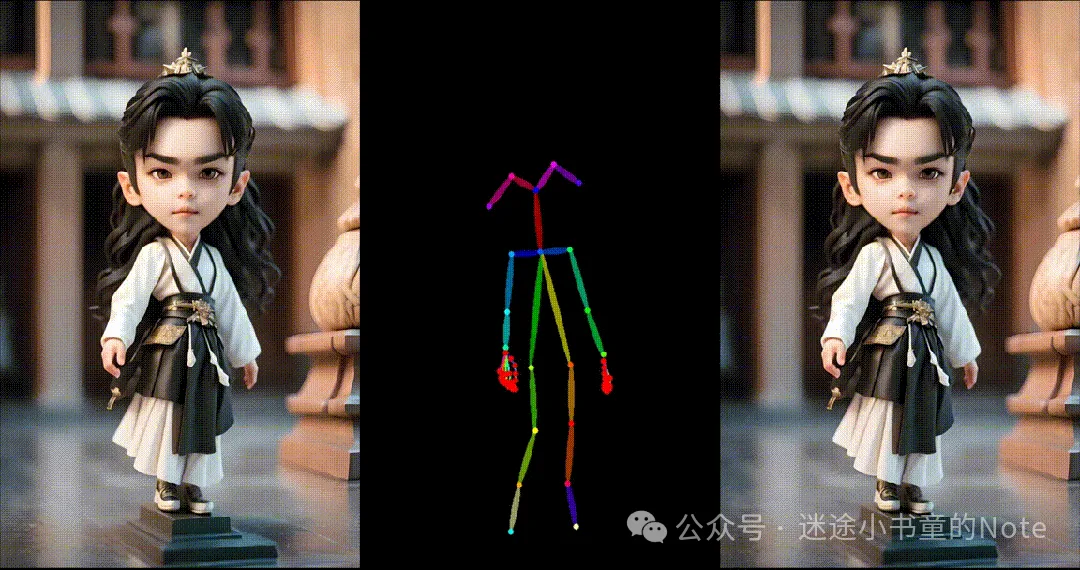

1. 华科等提出人类跳舞视频生成新框架UniAnimate

来自华中科技大学、阿里巴巴、中国科学技术大学的研究团队提出了 UniAnimate 框架,以实现高效且长时间的人类视频生成,支持合成1分钟高清视频。

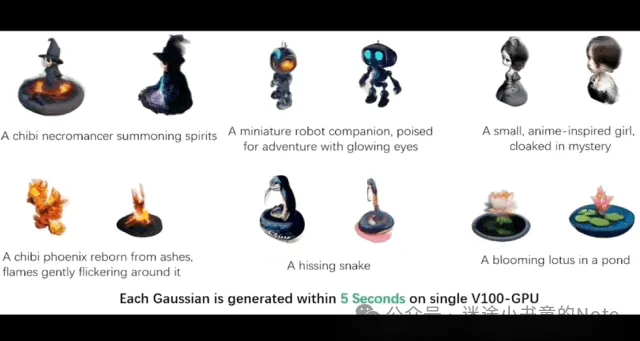

2. 5秒完成3D生成,合成数据集已开源

来自上海交大、香港中文大学等团队使用大模型合成的数据,显著提升了3D的生成能力。

他们推出Bootstrap3D框架,结合微调的具备3D感知能力的多模态大模型。这个框架能够自动生成任意数量的高质量的多视角图片数据,助力多视图扩散模型的训练。结果表明,新的合成数据能够显著提高现有3D生成模型的生成物体的美学质量和文本prompt的控制能力。目前,Bootstrap3D的数据集已经全面开源。

3. 字节推出效果更逼真的TTS技术

字节跳动团队提出了名为Seed-TTS技术,这是一系列大规模自回归文本转语音模型,能够生成几乎和人类语音无分别的语音。