在人工智能快速发展的今天,芯片技术的革新常常能引发整个行业的地震。就在9月4日,AI领域又传来一个重磅消息:PyTorch官方宣布实现了100%基于OpenAI的Triton语言推理的大语言模型。这一消息犹如一颗重磅炸弹,在AI圈内掀起了巨大波澜。那么,这到底意味着什么?是否预示着AI芯片领域即将迎来一场革命?

首先,我们需要了解什么是Triton。简单来说,Triton是一种由OpenAI开发的编程语言,专门用于GPU编程。它的出现,就像是给AI研究人员和开发者们送来了一把”魔法钥匙”,有望打破长期以来NVIDIA CUDA编程的垄断局面。

想象一下,如果你是一名AI研究员,过去你可能只能在NVIDIA的GPU上运行你的模型。但现在,使用Triton后,你的模型理论上可以在各种不同类型的GPU上运行,包括AMD的,甚至是未来的Intel GPU。这无疑大大拓宽了AI应用的硬件选择范围。

不仅如此,Triton还提供了更高级的抽象层,使得编写高性能GPU程序变得更加简单和快速。对于那些不愿意深入研究复杂的CUDA编程的开发者来说,这无疑是一个福音。

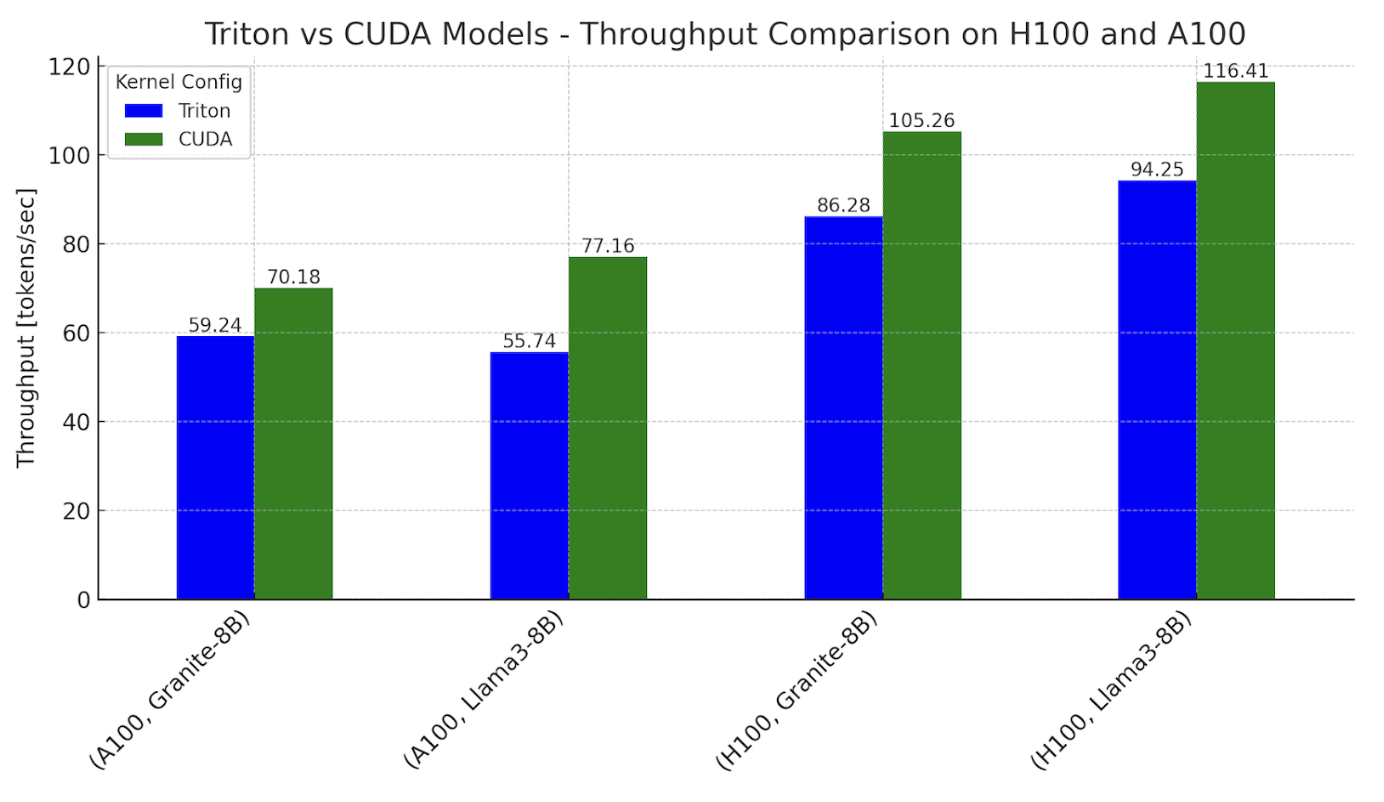

当然,面对新技术,我们最关心的莫过于其性能表现。PyTorch官方也给出了详细的测试数据。他们选择了两个当前流行的大模型——Meta的Llama3-8B和IBM的Granite-8B,分别在NVIDIA的H100和A100 GPU上进行了对比测试。

结果显示,在H100上,基于Triton的模型推理速度约为CUDA版本的76%到78%。而在A100上,这个数字则在62%到82%之间浮动。虽然还不及CUDA的性能,但已经相当接近了!要知道,CUDA已经发展多年,而Triton还只是一个新生儿。这样的表现已经足以让人惊喜了。

为什么会有这样的性能差异呢?PyTorch团队通过对比每个计算过程的延迟,给出了解释。主要的差距来自两个方面:

Triton的矩阵乘法(matmul)内核比CUDA慢1.2到1.4倍。

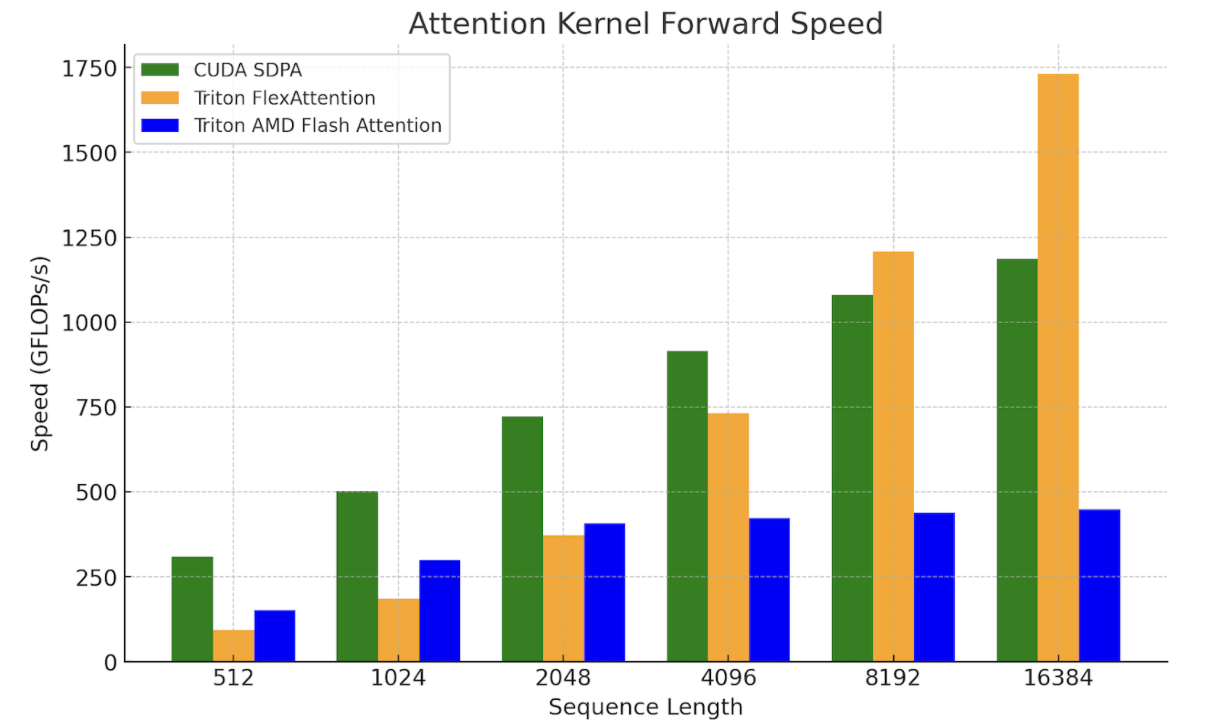

基于AMD的Triton Flash Attention内核比CUDA的SDPA(Scaled Dot-Product Attention)慢1.6倍。

但别灰心!PyTorch团队表示,他们正在积极探索优化方案。比如,他们测试了新的FlexAttention技术,在处理长上下文和解码问题时表现出了很大的潜力。

Triton的出现,无疑为AI芯片市场带来了新的可能性。长期以来,NVIDIA凭借其强大的CUDA生态系统,在AI芯片市场占据了绝对优势。但Triton的出现,可能会打破这种格局。

不过,我们也要看到,CUDA仍然保持着性能优势,而且拥有庞大的生态系统和用户群。Triton要真正挑战CUDA的地位,还有很长的路要走。