Ollama是什么

Ollama 是一个本地大模型运行框架,它允许用户在自己的计算机上运行和使用大型语言模型(LLM)。它的设计目标是简化大模型的运行过程,使得非专业的普通用户也能够轻松地玩转这些通常需要高端硬件和复杂设置才能运行的模型。目前 Ollama 已经支持了 windows、linux 和 macos。

实操

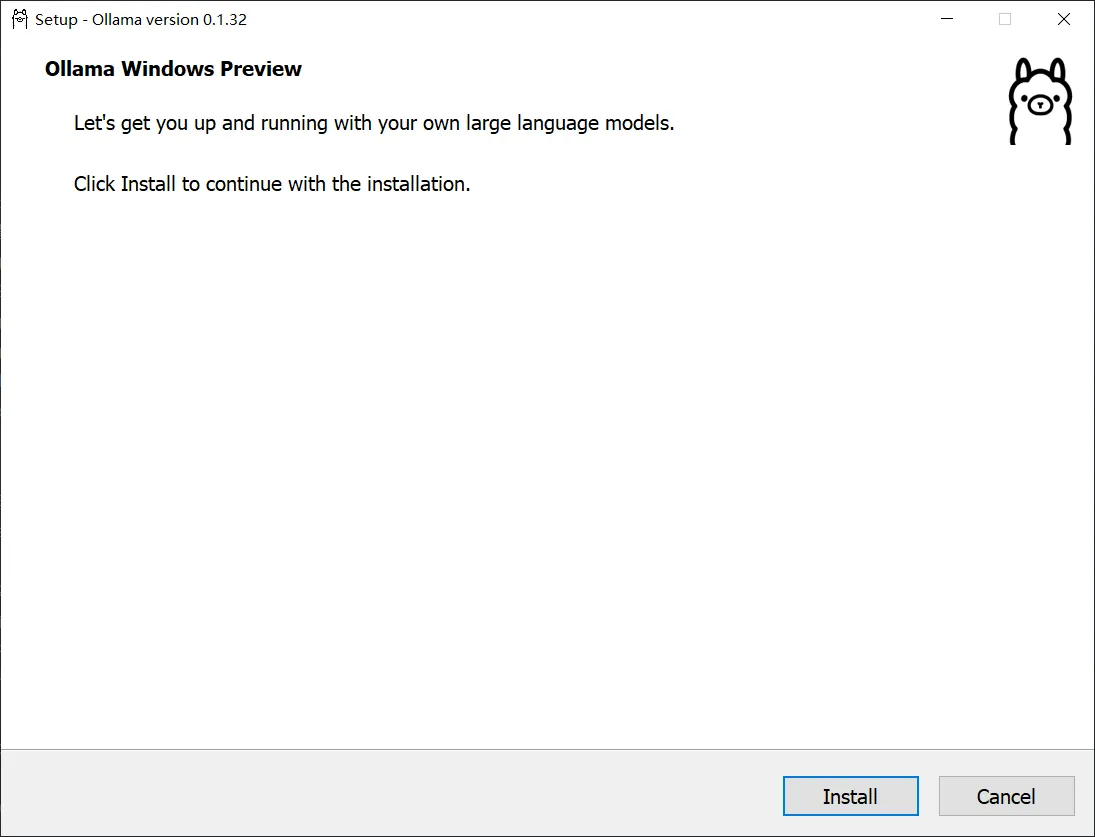

第一步,来到官方网站,地址是:https://ollama.com/download?utm_source=lobehub&utm_medium=docs&utm_campaign=download-windows

我这里是 windows 10系统,下载的是 exe 安装包

程序默认安装在了 C 盘,期间会拉取几个较大的文件,请确保有足够大的空间

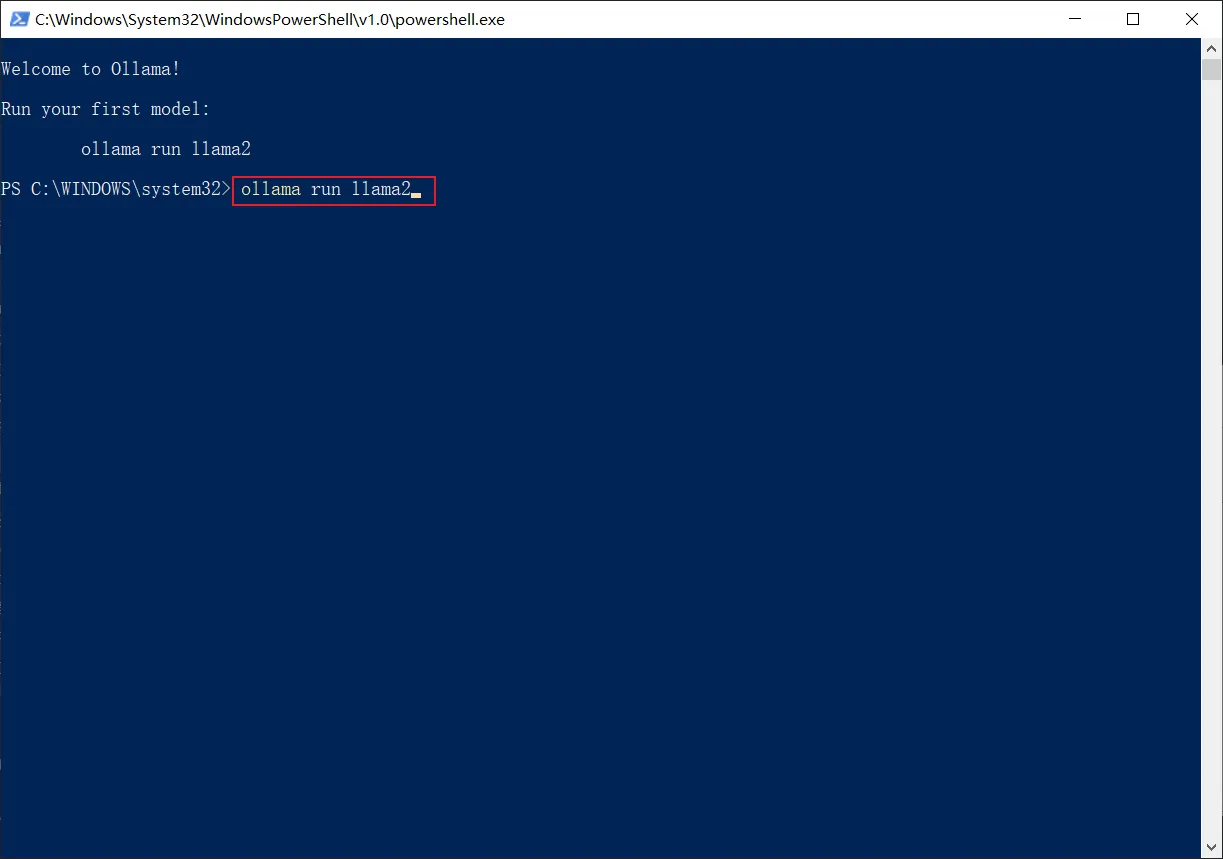

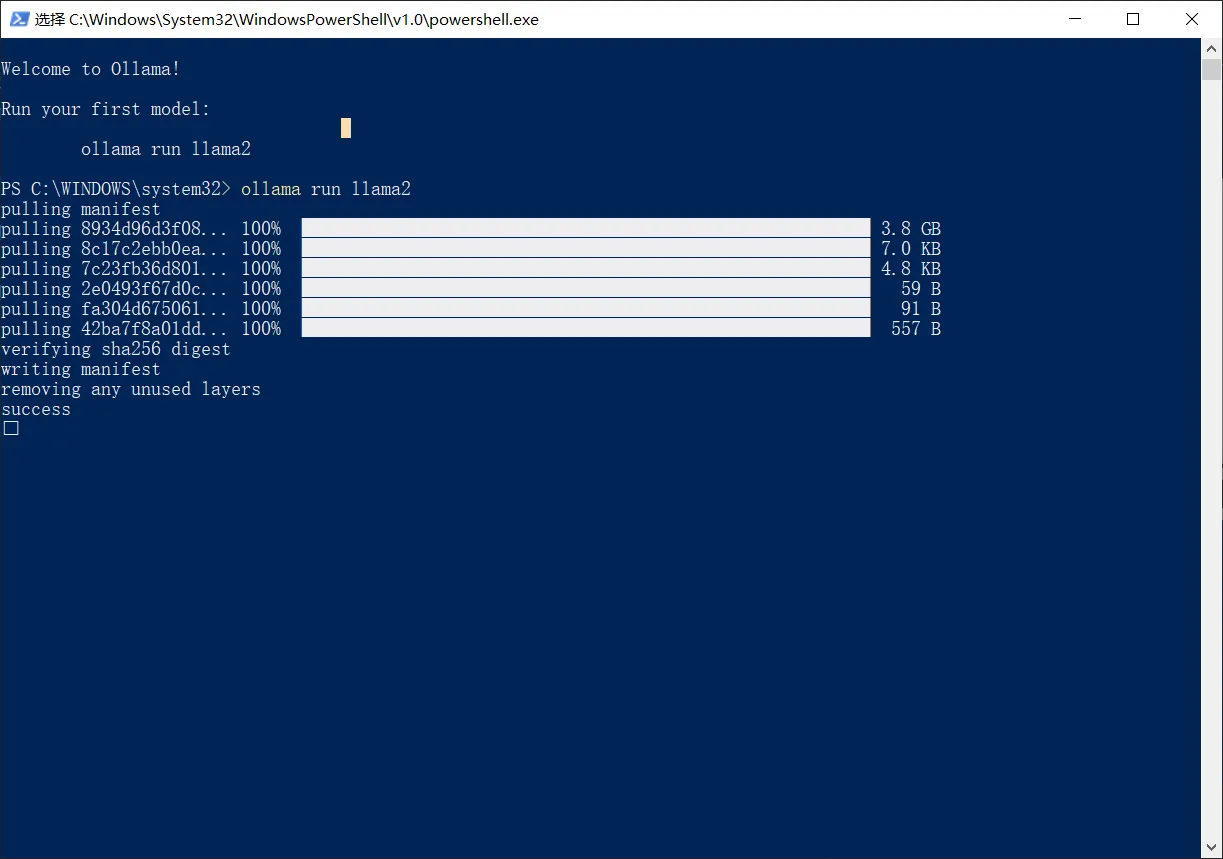

安装完成后,自动弹出 powershell,输入 ollama run llama2

看到 success,就安装成功了

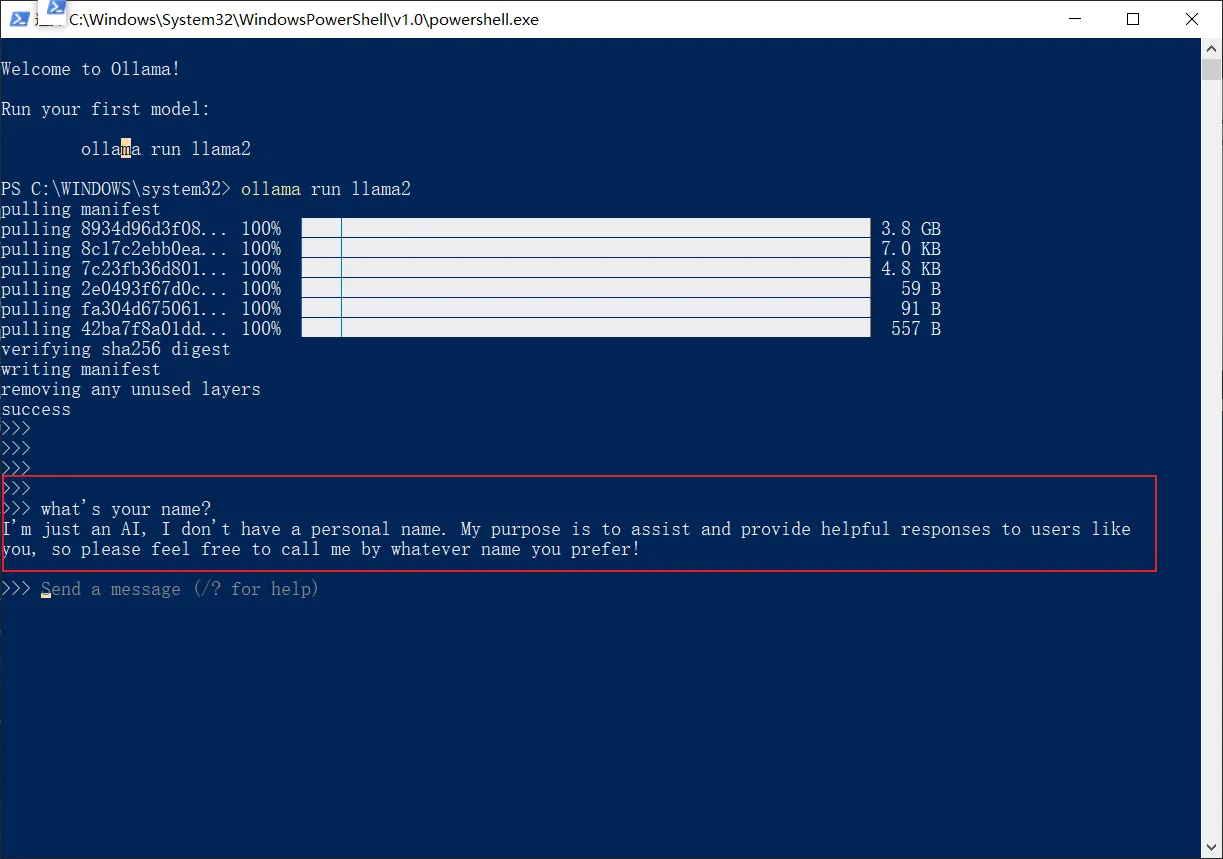

向大模型提个问题吧

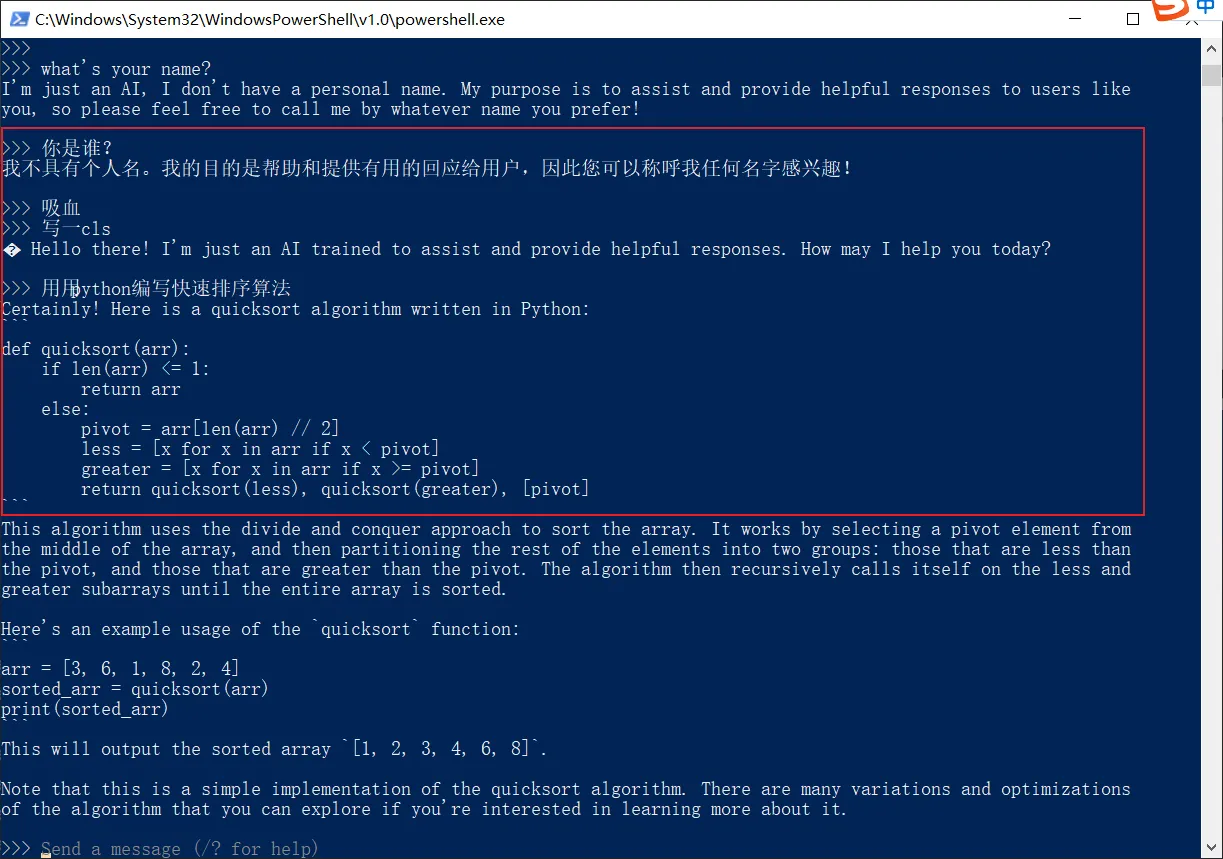

中文也能应付自如,不过有时候输入后,删除会不起作用,比较影响观感

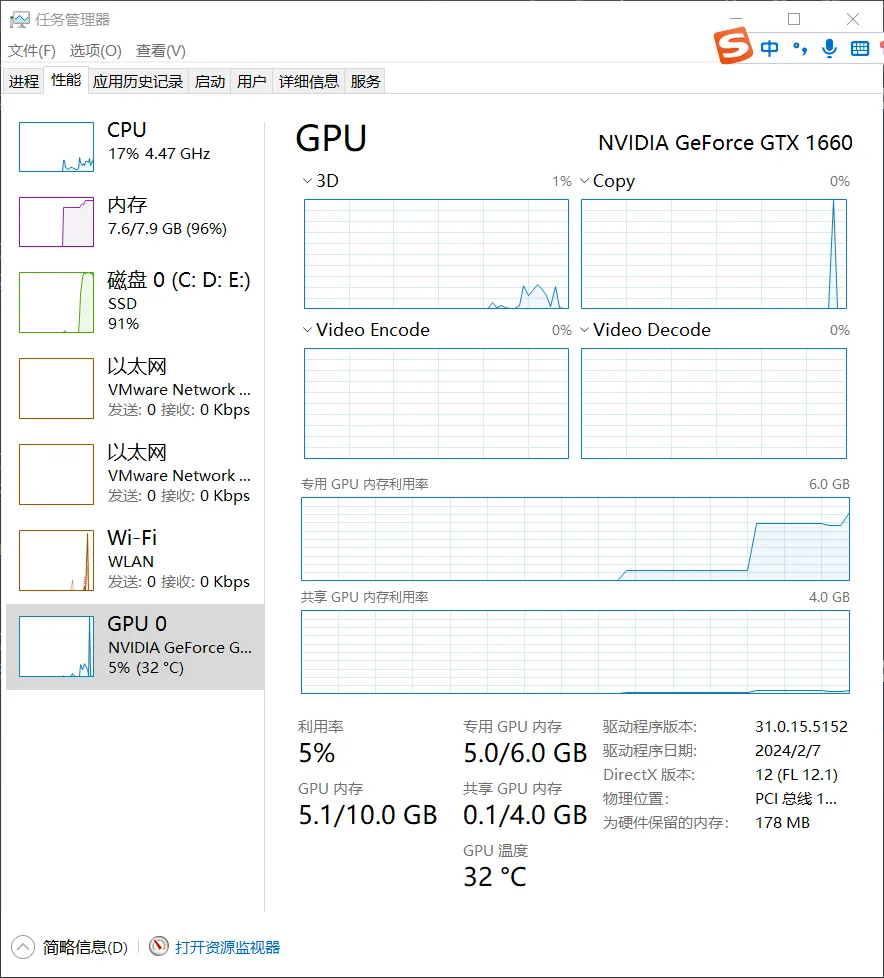

最后,说一下我的电脑配置,显卡是 Nivida GTX 1660 6G,运行完全没有问题。