李宏毅何许人也?

李宏毅老师,是宝岛台湾大学电机工程系教授,他分别于2010年和2012年获得硕士和博士学位,主要研究机器学习尤其是深度学习、语言理解和语音识别。李宏毅老师的机器学习课程可以说是最具代表性的中文公开课之一,已经成为大量国内初学者的首选。

2021年的机器学习课程已经全部更新完毕,全程中文讲解,覆盖的内容也非常丰富,视频均长40分钟。

课程目录

- 预测本频道观看人数(上)-机器学习基本概念简介

- 预测本频道观看人数(下)-深度学习基本概念简介

- 机器学习任务攻略

- 类神经网络训练不起来怎么办(一):局部最小值(

local minima)与鞍点(saddle point) - 类神经网络训练不起来怎么办(二):批次(

batch)与动量(momentum) - 类神经网络训练不起来怎么办(三):自动调整学习率(

learning rate) - 类神经网络训练不起来怎么办(四):损失函数(

loss)也可能有影响 - 类神经网络训练不起来怎么办(五):批次标准化(

batch normalization)简介 - 卷积神经网络(

Convolutional Neural Networks,即CNN) - 注意力机制(

self-attention)(上) - 注意力机制(

self-attention)(下) Transformer(上)Transformer(下)- 生成对抗网络(

Generative Adversarial Network,即GAN)(一) – 基本概念介绍 - 生成对抗网络(

Generative Adversarial Network,即GAN)(二) – 理论介绍与WGAN - 生成对抗网络(

Generative Adversarial Network,即GAN)(三) – 生成器效能评估与条件式生成 - 生成对抗网络(

Generative Adversarial Network,即GAN)(四) –Cycle GAN - 自监督式学习(

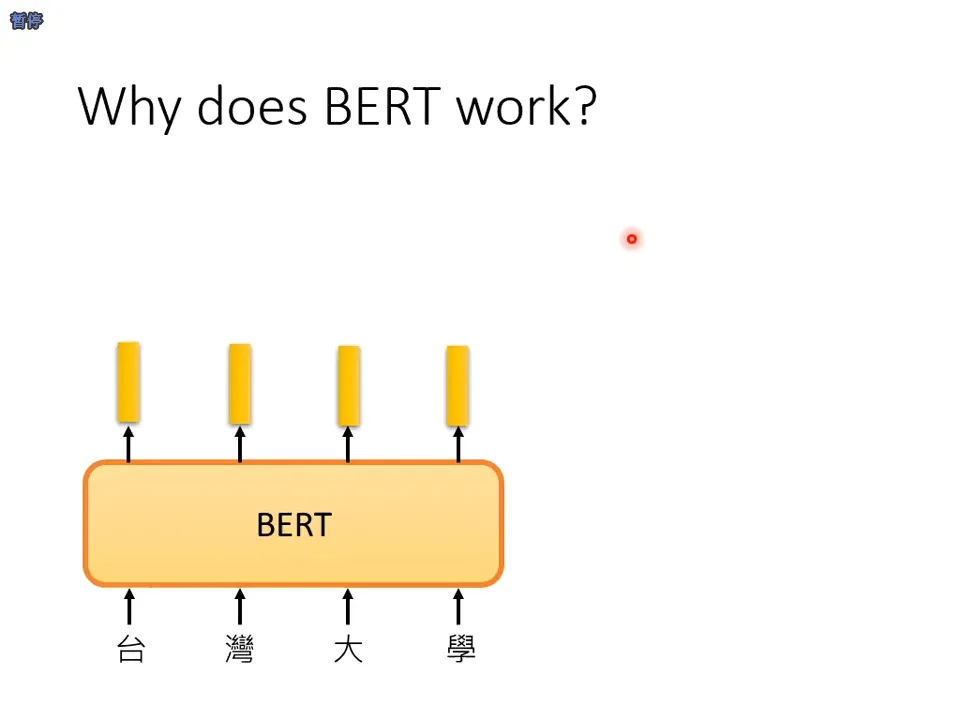

Self-supervised Learning) (一) – 芝麻街与进击的巨人 - 自监督式学习(

Self-supervised Learning) (二) –BERT简介 - 自监督式学习(

Self-supervised Learning) (三) –BERT的奇闻异事 - 自监督式学习(

Self-supervised Learning) (四) –GPT的野望 - 自编码器(

Auto encoder)(上) – 基本概念 - 自编码器(

Auto encoder)(下) – 领结变声器与更多应用 - 来自人类的恶意攻击(

Adversarial Attack) (上) – 基本概念 - 来自人类的恶意攻击(

Adversarial Attack) (下) – 类神经网络能否躲过人类深不见底的恶意? - 机器学习模型的可解释性(

Explainable ML) (上) – 为什么神经网络可以正确分辨宝可梦和数码宝贝呢? - 机器学习模型的可解释性(

Explainable ML) (下) – 机器心中的猫长什么样子? - 概述领域自适应(

Domain Adaptation) - 概述增强式学习(

Reinforcement Learning, RL) (一) – 增强式学习跟机器学习一样都是三个步骤 - 概述增强式学习(

Reinforcement Learning, RL) (二) –Policy Gradient与修课心情 - 概述增强式学习(

Reinforcement Learning, RL) (三) –Actor-Critic - 概述增强式学习(

Reinforcement Learning, RL) (四) – 回馈非常罕见的时候怎么办?机器的望梅止渴 - 概述增强式学习(

Reinforcement Learning, RL) (五) – 如何从示范中学习?逆向增强式学习 - 机器终身学习(

Life Long Learning, LL) (一) – 为什么今日的人工智能无法成为天网?灾难性遗忘(Catastrophic Forgetting) - 机器终身学习(

Life Long Learning, LL) (二) – 灾难性遗忘(Catastrophic Forgetting)的克服之道 - 神经网络压缩(

Network Compression) (一) – 类神经网络剪枝(Pruning)与大乐透假说(Lottery Ticket Hypothesis) - 神经网络压缩(

Network Compression) (二) – 从各种不同的面向来压缩神经网络 - 元学习

Meta Learning(一) – 元学习跟机器学习一样也是三个步骤 - 元学习

Meta Learning(二) – 万物皆可Meta - 课程结语 – 最后的作业并改编《为学一首示子侄》作结

下载地址

链接:https://pan.baidu.com/s/1szuFtJoR7nVK_IjWIZ64WA

提取码:i4vj